日本電信電話(NTT)は,情報処理システムの高性能化を目指した光インターコネクト技術を開発し,AI処理を高速化することに成功した(ニュースリリース)。

日本電信電話(NTT)は,情報処理システムの高性能化を目指した光インターコネクト技術を開発し,AI処理を高速化することに成功した(ニュースリリース)。

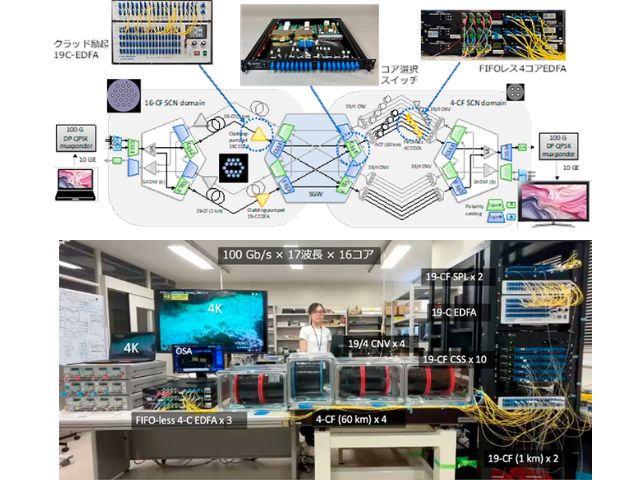

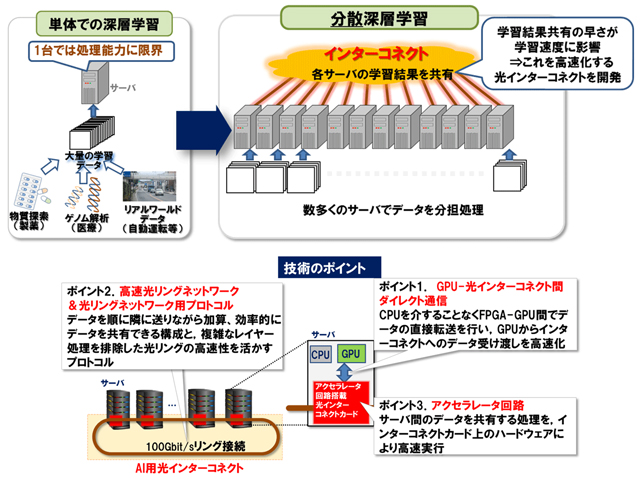

ポストムーア時代に向け,演算リソースを複数接続し能力向上を図る分散処理が情報処理装置の性能向上の手法として期待されるが,そのためには演算リソース間のデータ共有が高速に行なえる高性能なインターコネクトが必要となる。

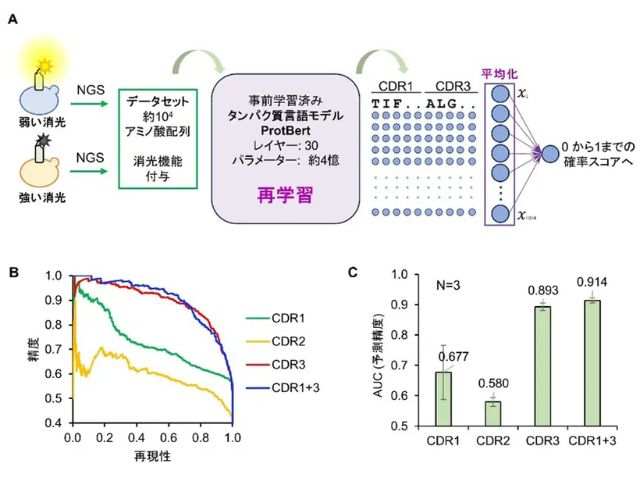

今回同社は,アプリケーションとしてAIに注目し,自動運転やゲノム解析などといった,リアルワールドの大量なデータを高速に処理するために数多くのサーバで分散処理を行なう「分散深層学習」に適した光インターコネクトを目指した。

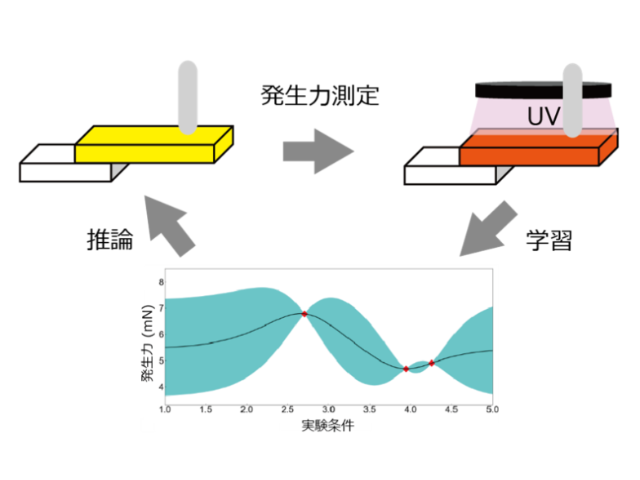

この成果の光インターコネクトは,分散深層学習のデータ共有の高速化を,以下の3点の技術的ポイントで実現している。

① CPUやメインメモリを介することなく,学習処理を行なうGPUと光インターコネクト間で直接データを授受できるようにし,演算リソース(GPU)と光インターコネクトをより密接に結び付けるGPU-光インターコネクト間ダイレクト通信

② データを順に隣に送りながら加算することで効率的にデータ共有が行える100Gb/sの高速光リングネットワークと,複雑なレイヤー処理を排除した光リングの高速性を活かすプロトコル

③ データ共有処理を専用のハードウェアで高速に実行するアクセラレータ回路

市販品で最速の構成とこの技術を用いた場合の比較測定を行っなた結果,4台のサーバ(1台当たり1GPU)を利用した場合,通信のために生じる演算待ち時間(通信オーバーヘッド)が84%以上削減されることを確認し,学習速度が7%向上することを確認した。

この測定結果をもとに,GPU台数を増やした場合の見積もりを行なうと,GPU台数を増やした場合では演算に対する通信の時間の比率が高まるため,通信時間短縮の効果が大きく現れ,32GPU利用時に40%以上学習速度が向上する見積もりが得られたという。

同社では,ポストムーア時代に向けた同社の技術構想「IOWN」の実現に向けた,光と電子の利点を結び付けた新アーキテクチャによる情報処理システムを実現する技術として,今回開発した技術を応用・発展させるとしている。