大阪大学の研究グループは,敵対的生成ネットワーク(GAN)によって薄雲を除去した航空写真をテクスチャとして貼り付けた3次元モデルを用いて,深層学習モデルの学習に利用するための建物マスク画像を自動的に生成する手法を提案した(ニュースリリース)。

大阪大学の研究グループは,敵対的生成ネットワーク(GAN)によって薄雲を除去した航空写真をテクスチャとして貼り付けた3次元モデルを用いて,深層学習モデルの学習に利用するための建物マスク画像を自動的に生成する手法を提案した(ニュースリリース)。

都市計画や建設の分野では航空写真から得られる情報が広く利用されている。例えば,土地がどのように利用されているかの調査や災害発生時に被害がどの程度かを確かめるために,航空写真からの情報を利用する。

また,無人航空機技術が普及したことで,リアルタイム性の高い高解像度の航空写真を多量に取得できるようになった。そこで,多量の写真を短時間で確認するために深層学習を用いた画像セグメンテーション技術が利用されている。

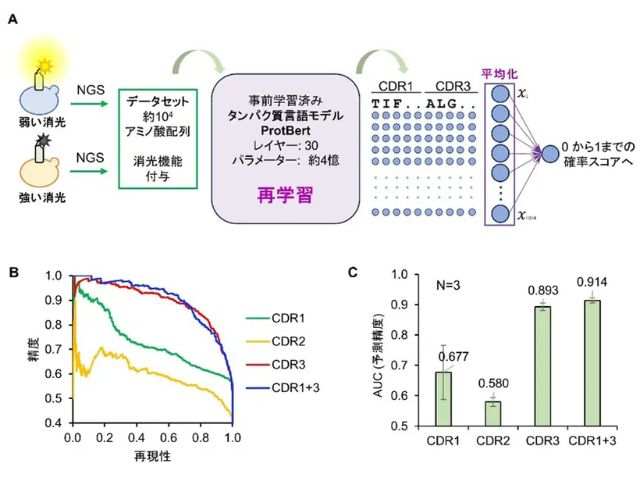

深層学習による画像セグメンテーションを行なうためには,多量の教師データが必要となる。教師データとは対象の画像とその画像のどこに目的の物体があるかを示したマスク画像のセットのことを指し,検出したい対象と同じ特徴を持った対象の教師データを多量に学習させる必要がある。

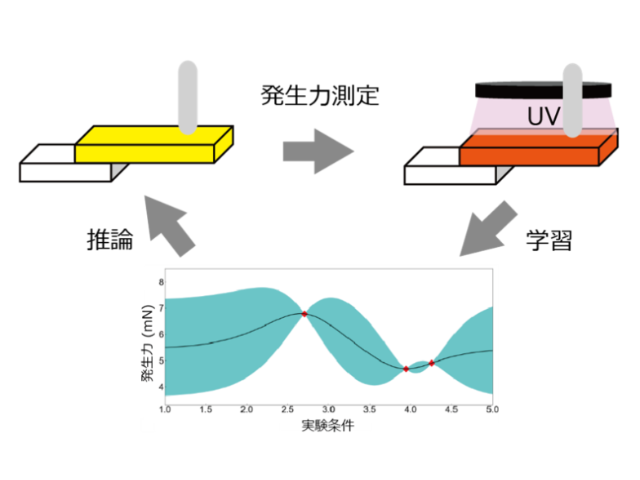

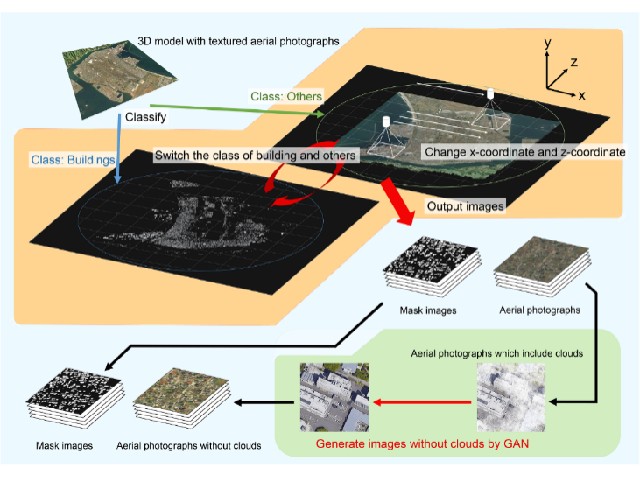

しかし,地方都市など教師データが提供されていない地域も多く存在し,多くの教師データはマニュアル操作によって作成されていることから新しいデータセットの作成には時間がかかるという課題がある。そこで効率的に教師データを生成するために,GANによって雲を除去した航空写真付き3次元モデルを用いた建物マスク画像自動生成手法を提案した。

開発したプロトタイプシステムは,汎用的なゲームエンジン上で航空写真をテクスチャとして貼り付けた3次元モデルをクラス分けし,表示させるクラスを切り替えることで仮想的なカメラから教師データとなるマスク画像と航空写真を出力する。次に,敵対的生成ネットワークによって航空写真上の雲を除去することで,高品質なデータセットを自動的に出力する。

この研究で提案した手法を用いることで,現在,教師データセットの提供されていない地域においても深層学習によってより高精度に建物を検出することができるため,研究グループは,土地利用調査や災害時の被害状況確認などをより効率的に行なうことができるようになるとしている。