筑波大学と豊橋技術科学大学の研究グループは,時間経過の様子を記録した大量の定点観測動画(タイムラプス動画)を学習データとして,一枚の景観画像から,時間が経過していく様子の高品質な動画を自動生成できる人工知能(AI)技術を開発した(ニュースリリース)。

筑波大学と豊橋技術科学大学の研究グループは,時間経過の様子を記録した大量の定点観測動画(タイムラプス動画)を学習データとして,一枚の景観画像から,時間が経過していく様子の高品質な動画を自動生成できる人工知能(AI)技術を開発した(ニュースリリース)。

AIの代名詞とも言えるディープラーニングの進歩により,一枚の静止画像から未来の動きを予測することが可能となってきた。しかし現在の最先端の技術でさえ,出力となる動画の解像度が128×128画素程度という低解像度であったり,出力できるフレーム数が32程度とごく短かったりと,低品質な出力に留まっていた。

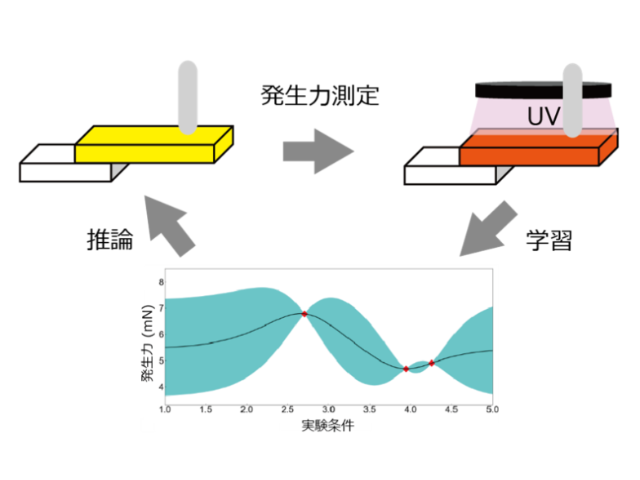

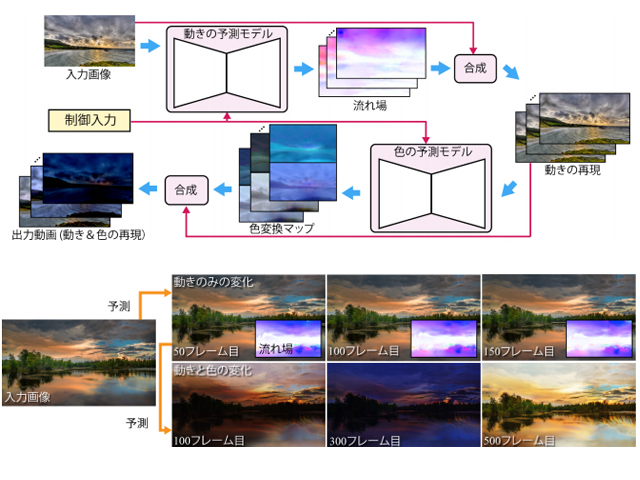

今回の研究は,物体の細かい動きと全体的な色の変化を扱うニューラルネットワークを別々に学習させる点がポイントとなる。このとき,細かい動きについては短い時間での変化を追う必要があるため,入力された画像から得られた出力画像を再度,入力として用いて予測する。

一方,全体的な色の変化については,時間間隔を広くとれるよう,入力画像からある時刻への色の変化を直接予測できるようにする。また,長期の予測を行なう場合,従来技術では誤差の累積が問題となる。

今回開発した技術では,誤差の累積の影響を受けにくい中間データを,流れ場や色変換マップとして予測するという,間接的なアプローチを採用している。これにより,例えば640×360画素で1,000フレーム以上といった,従来技術よりも格段に高品質な動画を出力できるようになったという。

さらに,一枚の静止画像から未来を予測する場合,例えば雲は右や左に動き得る,といった不確定性がある。これに対処するため,ニューラルネットワークによって抽出される潜在変数を用いて,動きや色を制御できる仕組みを組み込んだ。これにより,例えば,雲の動く方向や色の変化の仕方などを利用者が制御することができるとする。

研究グループは今後,人の歩行など,より複雑な動きの予測や,物理法則をより忠実に再現する課題に取り組みながら,景観予測シミュレーションなどへの応用可能性を開拓していく予定だとしている。