米オン・セミコンダクター(オンセミ)は,同社のイメージセンサー・モデリング技術を活用して,米NVIDIAのシミュレーション・プラットフォーム「DRIVE ConstellationTM」に,リアルタイムのデータを提供することを発表した(ニュースリリース)。

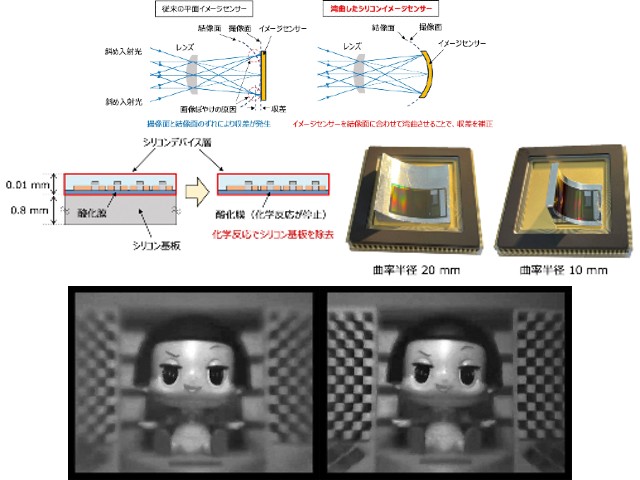

オンセミのイメージセンサーのモデルは,周囲の情報と制御信号の両方を「DRIVE Constellation」から受信し,その入力に基づきリアルタイムの画像を計算し,出力する。そして,そのシミュレーションされた画像を,「DRIVE Constellation」の処理のために戻す。

このセンサーモデルは,写真をデジタル出力に変換する過程のすべての重要パラメータ(量子効率,ノイズ,ゲイン,アナログ・デジタル変換,黒レベル補正など)を活用し,リアルタイムで正確なイメージセンサーデータを提供する予定だという。

これにより,このプラットフォームは,大規模なHILS(hardware-in-the-loop)テストと自律運転車の検証用に,ビット単位の精度を持つシミュレーションができるとしている。

オンセミは,カリフォルニア州サンノゼで開催されたNVIDIAの「GPUテクノロジー・カンファレンス(GTC)」(2019年3月18日~21日)の327番ブースで,先進のセンサー・シミュレーションのモデル,およびオブジェクト検出用に開発された新しいツールのデモを実施した。

このブースでは,プラットフォームに接続された業界最高レベルのセンサーのデモを行なった。同社は「DRIVE PegasusTM」プラットフォームとともに使用できる,1メガピクセルから12メガピクセルまでの車載用CMOSイメージセンサー製品を提供している。